Detailbeschreibung

AUSGANGSLAGE

- Zu wissen, wann man der Antwort eines KI-Modells vertrauen kann, kann entscheidend sein.

- Solche Entscheidungen sind in vielen Anwendungen relevant, von autonomen Fahrzeugen bis hin zu Finanzinvestitionen.

- Die meisten Ansätze zur Schätzung des KI-Vertrauens bieten vereinfachte Messwerte.

- Diese sind nicht zuverlässig, um die zukünftige Richtigkeit der KI vorherzusagen.

- Sie sind besonders schwach, wenn KI-Modelle außerhalb ihres Trainingsumfangs verwendet werden.

- Beispiel: Verwendung eines üblichen Gesichtserkennungsmodells zur Erkennung von Gesichtern unter Wasser.

LÖSUNGSANSATZ

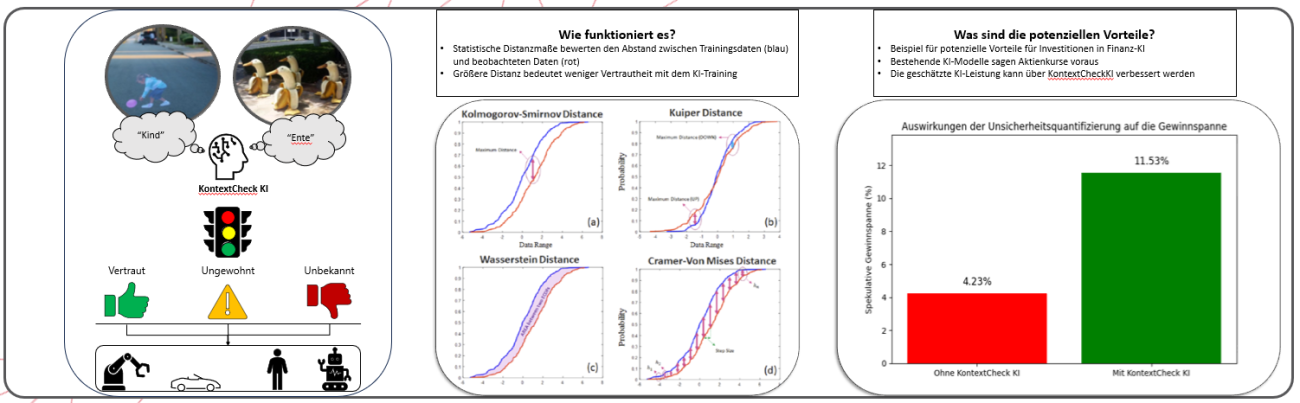

KontextCheck KI:

- Bewertet die Eingaben des KI-Modells statistisch und vergleicht sie mit einer repräsentativen Stichprobe des Trainings des KI-Modells.

- Bietet einen besseren Indikator, um die Trainingsrelevanz einer KI für die beobachteten Eingaben zu erkennen.

- Ermöglicht Endbenutzern oder anderen Systemen, auf einen “Plan B” zurückzugreifen, wenn die KI bei kritischen Entscheidungen als unzuverlässig erachtet wird.

POTENZIAL & ANWENDUNGSBEREICHE

- Macht Endbenutzer oder Hostsysteme darauf aufmerksam, wenn das KI-Modell unzuverlässig sein könnte.

- Ermöglicht die Berücksichtigung von Plan-B-Lösungen, wenn nötig:

- alternative Modelle verwenden

- „sichere“ Entscheidungen treffen, z. B. autonomes Fahrzeug zum Stillstand bringen

- Anwendbar in Systemen, die KI-Modelle verwenden, einschließlich:

- autonome Systeme, z. B. autonome Fahrzeuge

- KI-Investitionsmodelle

- medizinische Scan- und Diagnosemodelle